Robots.txt چیست؟

فایل Robots.txt

خیلی عالی است که موتورهای جستجو غالباً از سایت شما بازدید می کنند و محتوای سایت شما را فهرست می کنند ، اما غالباً مواردی وجود دارد که فهرست بندی قسمت های محتوای آنلاین شما همان چیزی نیست که شما می خواهید. به عنوان مثال ، اگر دو نسخه از یک صفحه (یکی برای مشاهده در مرورگر و دیگری برای چاپ) دارید ، ترجیح می دهید نسخه چاپی را از خزیدن ربات های جستوجو خارج نکنید ، در غیر این صورت خطای محتوای تکراری را ایجاد می کنید. همچنین ، اگر اتفاقاً در سایت خود داده های حساس دارید که نمی خواهید کسی آنها را مشاهد کند ، شما نیز ترجیح می دهید موتورهای جستجو این صفحات را ایندکس نکنند (اگرچه این حالت تنها راه مطمئن برای فهرست نویسی داده های حساس نیست. آن را به صورت آفلاین در دستگاه جداگانه نگه دارید). علاوه بر این ، اگر می خواهید با حذف تصاویر ، stylesheets و جاوا اسکریپت از فهرست بندی ، مقداری از پهنای باند را ذخیره کنید ، به روشی نیز نیاز دارید که به عنکبوت ها بگویید تا از این موارد دوری کنند.

یکی از راه های گفتن به موتورهای جستجوگرکه از پرونده ها و پوشه ها در وب سایت شما دوری کنند ، استفاده از متاتاگ ربات ها است. اما از آنجایی که همه موتورهای جستجو متاتاگ را نمی خوانند ، ماتاگاگ ربات ها به سادگی می توانند بدون توجه به این موضوع مورد توجه قرار نگیرند . یک راه بهتر برای اطلاع موتورهای جستجو در مورد خواست شما استفاده از فایل robots.txt است.

Robots.txt چیست؟

Robots.txt یک فایل متنی (نه اچ تی ام ال) است که در سایت خود قرار داده اید تا به روبات های جستجو بگویید کدام صفحاتی را که دوست دارید یا دوست ندارید بازدید کنند یا نکنند. Robots.txt به هیچ وجه برای موتورهای جستجو الزامی نیست ، اما به طور کلی موتورهای جستجو از آنچه خواسته می شود انجام ندهند پیروی می کنند. توضیح این نکته مهم است که robots.txt راهی برای جلوگیری از خزیدن موتورهای جستجو در سایت شما نیست (یعنی آن یک فایروال یا نوعی محافظت از رمز عبور نیست) و این واقعیت که شما یک فایل robots.txt قرار داده اید ، چیزی شبیه به این است قرار دادن یادداشت "لطفاً وارد نشوید" روی درب قفل نشده است - به عنوان مثال شما نمی توانید از ورود سارقان جلوگیری کنید اماافراد فهمیده وارد خانه ای درش باز است نمی شوند. به همین دلیل می گوییم که اگر شما داده های قدیمی زیادی دارید ، خیلی ساده است که به robots.txt اعتماد کنید تا از ایندکس شدن و نمایش دادن در نتایج جستجو در نمایه سازی محافظت کنید.

مکان robots.txt بسیار مهم است. این باید در دایرکتوری اصلی باشد زیرا در غیر این صورت عوامل کاربر (موتورهای جستجو) قادر به یافتن آن نخواهند بود - آنها کل سایت را برای پرونده ای به نام robots.txt جستجو نمی کنند. در عوض ، آنها ابتدا به دایرکتوری اصلی ( http://mydomain.com/robots.txt) نگاه می کنند و اگر آنها را در آنجا پیدا نکردند ، به سادگی فرض می کنند که این سایت فایل robots.txt ندارد و بنابراین آنها هر آنچه را که در طول مسیر پیدا می کنند فهرست بندی کنید. بنابراین ، اگر robots.txt را در جای مناسب قرار ندهید ، تعجب نکنید که موتورهای جستجوگر کل سایت را فهرست می کنند.

مفهوم و ساختار robots.txt بیش از یک دهه قبل ایجاد شده است و اگر شما می خواهید اطلاعات بیشتری در مورد آن کسب کنید ، به http://www.robotstxt.org مراجعه کنید یا می توانید مستقیماً به استاندارد برای ممانعت روبات مراجعه کنید زیرا در این مقاله ما فقط با مهمترین جنبه های فایل robots.txt سروکاردازیم . در مرحله بعدی با ساختار یک فایل robots.txt اشنا می شوید.

ساختار یک فایل Robots.txt

ساختار robots.txt بسیار ساده (و به سختی قابل انعطاف) است - این یک لیست بی پایان از عوامل کاربر است وفایل ها و دایرکتوری های مجاز نیست. در اصل ، این فایل به شرح زیر است:

:User-agent

:Disallow

“User-agentare search engines' crawlers and disallow: lists the files and directories to be excluded from indexing. In addition to “user-agent:” and “disallow:” entries, you can include comment lines – just put the # sign at the beginning of the line

. All user agents are disallowed to see the /temp directory#

:#User-agent

/Disallow: /temp

تله های فایل Robots.txt

هنگامی که شروع به ساخت فایل های پیچیده می کنید - به عنوان مثال تصمیم می گیرید که اجازه دسترسی عوامل مختلف کاربر را به دایرکتوری های مختلف را بدهید - اگر به تله های یک فایل robots.txt توجه خاصی نکنید ، مشکلات می توانند شروع شوند. اشتباهات رایج شامل دستورالعمل های مقصر و متناقض است. Typos عامل های کاربر نادرست ، دایرکتوری ها ، ستون های از دست رفته پس از کاربر-عامل و Disallow ، و غیره هستند. Typos می تواند مرموزانه پیدا شوند اما در بعضی موارد ابزارهای اعتبار سنجی به شما کمک می کنند.

مشکل جدی تر با خطاهای منطقی است. برای مثال:

*:User-agent

/Disallow: /temp

User-agent: Googlebot

/Disallow: /images

/Disallow: /temp

/Disallow: /cgi-bin

مثال فوق از robots.txt است که به همه نمایندگان امکان می دهد به همه موارد موجود در سایت دسترسی داشته باشند ، به جز فهرست / temp. تا اینجا خوب است اما بعداً یک رکورد دیگر وجود دارد که شرایط محدود کننده تری را برای Googlebot مشخص می کند. هنگامی که Googlebot خواندن robots.txt را شروع می کند ، می بیند که همه عوامل کاربر (از جمله خود Googlebot) به همه پوشه ها به جز / temp /دسترسی دارند. این کافی است که Googlebot بدانید ، بنابراین این فایل را تا انتها نخوانده و همه موارد را به جز / temp / - از جمله / تصاویر / و / cgi-bin / ، فهرست بندی می کند ، که فکر می کنید به آن گفته ایدمجاز نیستند. می بینید که ساختار یک فایل robots.txt ساده است اما با این وجود اشتباهات جدی به راحتی قابل انجام است.

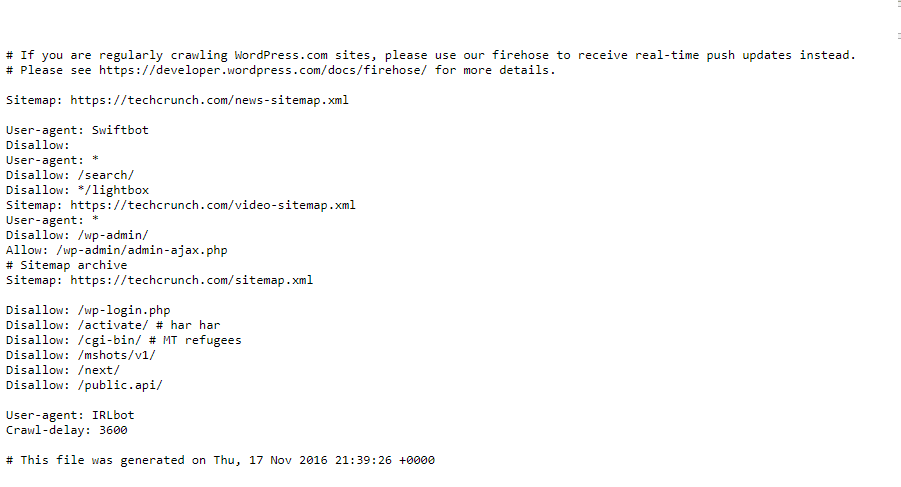

عکس زیر نمونه ای یک فایل robots.txt است:

ابزاری برای تولید و اعتبارسنجی پرونده Robots.txt

با توجه به ایجاد ساده یک فایل robots.txt ، همیشه می توانید آن را بخوانید تا ببینید همه چیز درست است اما استفاده از یک اعتبار سنج مانند این یکی بسیار ساده تر است: http://tool.motoricerca.info/robots- checker.phtml این ابزارها در مورد اشتباهات رایج مانند گم شدنslashes یا colonsگزارش می دهند ، که در صورت عدم شناسایی تلاش های شما را به خطر می اندازند. به عنوان مثال ، اگر تایپ کرده اید:

*:User agent

/Disallow: /temp

این اشتباه است زیرا بین "کاربر" و "نماینده"هیچ slashوجود ندارد وترکیب نادرست است.

در این موارد ، هنگامی که شما یک فایل robots.txt پیچیده دارید - یعنی دستورالعمل های مختلفی را به عوامل مختلف کاربر می دهید یا یک لیست طولانی از فهرست ها و زیر شاخه ها برای حذف آنها دارید ، نوشتن فایل به صورت دستی می تواند یک درد واقعی باشد. اما نگران نباشید - ابزاری وجود دارد کهفایل را برای شما تولید می کند. علاوه بر این ، ابزارهای تصویری وجود دارد که به آنها امکان نشان دادن و انتخاب پرونده ها و پوشه ها را نمی دهند. اما حتی اگر شما خرید ابزار گرافیکی برای نسل robots.txt احساس نمی کنید ، ابزار آنلاین وجود دارد که به شما کمک می کند. به عنوان مثال ، ژنراتور روبات های سرور جانبی یک لیست کشویی از عوامل کاربر و یک جعبه متن را برای شما ارائه می دهند تا فایل هایی را که نمی خواهید فهرست بندی کنید ، در اختیار شما قرار دهد. صادقانه بگویم ، خیلی کمک نمی کند ، مگر اینکه بخواهید برای موتورهای جستجوی مختلف قوانین خاصی را تعیین کنید ، زیرا به هر حال این وظیفه شماست که لیست دایرکتوری ها را تایپ کنید